La « directive sur le droit d’auteur dans le marché unique numérique », aussi appelée « directive copyright », est actuellement en cours d’examen au parlement européen ; les amendements (V6 du document) seront votés le 20 juin 2018 en commission “JURI”.

J’ai écrit le texte qui suit pour établir un argumentaire avant d’appeler quelques députés européens (pour être plus convaincant, il vaut mieux connaître son sujet), participant ainsi à la campagne lancée par le site saveyourinternet.eu.

Je vous invite à en faire autant, non sans avoir lu quelques unes des références citées en fin de page, et consulté https://juliareda.eu/2018/06/saveyourinternet/ pour connaître les partis et députés qui sont susceptibles de faire pencher la balance.

Deux articles sont particulièrement problématiques, l’article 11, qui concerne la citation d’articles de presse, mais dont nous ne parlerons pas ici, et surtout l’article 13, qui vise à mettre en œuvre des filtres sur tous les sites participatifs (c’est à dire, visant à partager du contenu, de quelque nature qu’il soit, ceci incluant donc les réseaux sociaux).

L’objectif poursuivi par l’article 13 de la directive est de protéger les ayants-droit de l’industrie du divertissement contre l’hégémonie des plateformes de partage, notamment Youtube, qui provoqueraient une “évasion” de revenus lorsque des œuvres leur appartenant sont diffusées illégalement sur ces plateformes.

La solution proposée est d’instaurer une obligation légale de systèmes de “listes noires” de contenus protégés., sur tous les sites en ligne, et de tous les contenus, même de ceux qui n’ont pas besoin de protection (par exemple, le code source de logiciel informatique).

Nous allons voir comment de tels systèmes fonctionnent, pourquoi ils sont complexes à mettre en œuvre avec des dégâts collatéraux significatifs, et pourquoi le but recherché est déjà atteint sur les plateformes visées, rendant l’article 13 néfaste.

Les systèmes de “liste noire” de contenus

On peut les classer en trois catégories :

Les systèmes de détection “à l’identique”

Relativement peu coûteux en ressources, ils fonctionnent sur le contenu numérique des fichiers concernés, et n’ont pas besoin de connaître le format ou le type de média, ni même le détail du contenu à protéger, grâce à l’utilisation d’algorithmes de “hachage” (ou “résumé”).

Ces caractéristiques rendent ces systèmes très simples à implémenter et exploiter, et peu coûteux. Les algorithmes concernés sont des logiciels libres / open source, ou libres de droits, et faciles à adapter à toute plateforme technique.

En revanche, ces systèmes sont très faciles à contourner, par simple modification mineure du fichier concerné. Ils ont donc une utilité très limitée pour protéger les détenteurs de droits.

Les systèmes de détection “par similarité”

Ces systèmes sont beaucoup plus complexes. Ils ont la connaissance des formats employés, et en extraient des éléments “caractéristiques”, une sorte d’empreinte digitale du contenu à protéger. Ce procédé d’empreinte permet de détecter un contenu même très altéré, par exemple un fond musical à peine audible dans une vidéo de fête familiale ou de théâtre amateur.

Le plus connu, auquel font fréquemment référence les réactions à l’article 13, est Content-Id, de Youtube, décrit ici par Google.

Les systèmes “par similarité” sont très coûteux à développer et à exploiter. Google cite la somme de plus de 100 millions de dollars d’investissement pour Content-Id. Il n’en existe pas d’implémentation libre de droits, ce qui les rend d’autant plus difficiles à mettre en œuvre : il faut, ou bien développer un système “à façon”, ou bien acquérir une licence d’un système commercial existant, s’il en existe. Les sociétés en mesure de proposer de tels mécanismes très spécifiques sont rares.

Par ailleurs, la qualité des résultats (taux de faux positifs ou faux négatifs) de ces algorithmes est difficile à estimer, d’abord pour les raisons qui précèdent (systèmes propriétaires à accès limité), ensuite parce que les systèmes techniques de détection n’ont pas une fiabilité absolue.

Enfin, ces systèmes souffrent d’un autre défaut important : comme l’explique Google dans la vidéo ci-dessus, les ayants-droit doivent fournir les originaux ou des extraits des contenus à protéger, ce qui est difficile à mettre à œuvre à grande échelle (beaucoup d’œuvres et beaucoup d’acteurs).

Les systèmes par “marquage”

Ces systèmes dits de watermarking, évoqués dans les annexes de la directive, ne sont cités ici que pour mémoire. Ils ont des coûts similaires aux systèmes par similitude, mais sont d’application limitée, peu envisageables dans le cas de l’article 13.

La gestion des listes noires

La gestion des listes constitue, indépendamment des procédés techniques qui précèdent, un problème en soi.

Ni l’article 13 en sa rédaction originale, ni les amendements proposés, qui le complexifient considérablement, ne proposent de solution suffisante aux problèmes sous-jacents :

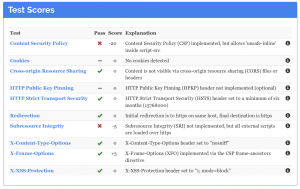

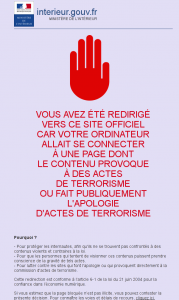

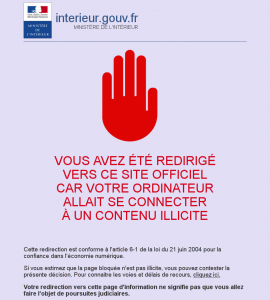

- risque de sur-blocage : blocage de contenus qui ne sont pas en infraction, en raison d’un enregistrement abusif par un détenteur de droit supposé, blocage de contenus bénéficiant d’une exception (mèmes, parodies, etc) dans lesquels les automates ont reconnu un contenu protégé. Le risque existe si la liste noire est mal alimentée, ce qui a déjà été observé dans d’autres contextes, par exemple à plusieurs reprises avec le système national de blocage DNS de la police française, y compris par des systèmes de test mal configurés : voir Google.fr bloqué pour apologie du terrorisme suite à une « erreur humaine » d’Orange).

- risque de sous-blocage : non blocage de contenus soumis à droits. L’enregistrement des contenus est lourd à mettre en œuvre ; de nombreux contenus n’ont même jamais été numérisés par leurs détenteurs légitimes

- L’ajout en liste noire peut nécessiter une vérification manuelle, donc lourde, pour réduire les taux de faux positifs sans pour autant les faire disparaître.

- lourdeur et manque de fiabilité des procédures de contestation : tous les cas de sur-blocage ou de sous-blocage doivent être traités par intervention humaine, voire judiciaire. Or, les cas de censure abusive sont quotidiens ; cela a été observé avec le DMCA (Digital Millenium Copyright Act) états-unien, où des détenteurs de droits ont engagé des procédures sur des œuvres qui ne leur appartenaient pas, sur similarité de titre, ou par détournement de finalité pour obtenir le retrait de listes de comparateurs de prix. L’amateur est démuni devant la lenteur et le coût d’un recours éventuel en justice en cas de blocage abusif.

Ni l’article 13 originel, ni les amendements ne répondent de manière satisfaisante à ces points, et en particulier au problème des blocages abusifs, où la solution de dernier recours proposée est une procédure en justice.

Le système Content-Id

Bien qu’appartenant à Google et spécifique à Youtube, ce système nécessite un examen plus détaillé. Il semble en effet avoir servi de modèle implicite à l’article 13.

Content-Id est un système de détection “par similarité”. Pour en bénéficier, les détenteurs de droits doivent fournir à Youtube des vidéos à protéger, ou des échantillons.

Ensuite, 3 options sont proposées en cas de détection d’un contenu “à protéger” :

- bloquer la vidéo

- monétiser celle-ci (publicité)

- obtenir des données de consultation, pour savoir par exemple dans quels pays la vidéo est populaire

Selon Google, Content-Id a déjà permis le reversement de plusieurs milliards de dollars de revenus. Le système inclurait des centaines de millions de vidéos.

Impact de la directive

Le résumé de l’étude d’impact joint au projet de directive est très incomplet : en comparaison de l’étude d’impact complète, il ne parle que très partiellement de l’impact pour les détenteurs de droits, se limitant à une réflexion juridique sur le marché unique, et n’évoque pas l’efficacité et la faisabilité technique des mesures, ni l’impact sur les sites et l’écosystème Internet. Il est conseillé de se reporter à l’étude d’impact complète.

1. Disparition ou marginalisation des sites contributifs

Les sites de partage de contenus libres et sites contributifs n’auront pas les ressources financières pour exploiter, a fortiori développer, ni même louer, des systèmes équivalents à Content-Id.

L’étude d’impact fournit un exemple de coût d’abonnement à un tel service : 900€/mois pour un petit site (5000 transactions/mois, soit 0,18€/transaction).

Mais l’étude n’en considère l’impact que pour des sites commerciaux dont le partage est la vocation principale, omettant donc l’impact négatif sur les sites participatifs et contributifs à fort volume (tels que Wikipédia), les réseaux sociaux, les sites de partage de photos amateurs ou familiales, petites annonces, etc, pour lesquels les revenus sont inexistants ou faibles en comparaison des coûts d’une vérification a priori des contenus.

Ce premier impact sur la liberté d’expression est donc minimisé.

2. Tous les contenus sont visés

Les systèmes de protection des droits d’auteur actuellement déployés s’intéressent essentiellement aux contenus qui concernent l’industrie du divertissement :

- vidéos et films

- musiques

Or, les partages sur Internet concernent bien d’autres types de contenus, notamment :

- logiciels en source (logiciel libre)

- photographies

Là encore, l’impact sur le coûts de fonctionnement des services en ligne concernés sera significatif, avec les mêmes risques de censure abusive des contenus, donc impact amplifié sur tous les autres points cités ici.

3. Dangers à l’égard de la liberté d’expression

Comme l’ont signalé de nombreuses associations, et comme expliqué ici, les systèmes par similarité sont incapables de distinguer une contrefaçon, un plagiat, une parodie, un mème, etc. Il est également fréquent que des œuvres libres de droit se retrouvent indûment répertoriées, par exemple parce qu’elles sont apparues ou ont été citées dans une œuvre soumise à droits (reportage télévisé, émission, etc).

Dans tous ces cas, les robots de détection produisent déjà, là où ils sont mis en œuvre, des censures abusives. Forcer l’extension de leur usage par la directive ne peut donc résulter qu’en des atteintes supplémentaires et sérieuses à la liberté d’expression, tout particulièrement sur les réseaux sociaux, rendant impossible ou difficile l’exercice des exceptions légales citées ci-dessus.

Enfin, comme exprimé précédemment, l’élargissement à tous les types de contenus ne peut qu’accentuer ce risque.

4. Inefficacité du dispositif pour protéger les ayants-droit

Comme on l’a vu, les systèmes de type Content-Id ne sont pas généralisables en raison de leur coût, et les systèmes de détection de contenus à l’identique sont faciles à contourner.

En outre, ces systèmes sont déjà mis en œuvre sur les grands sites, comme l’étude d’impact le reconnaît :

In all, as content recognition technologies are already applied by the major user uploaded content services, it is likely that this option would not lead to significant increases in unjustified cases of prevented uploads compared to the current situation

L’étude estime que l’article 13 ne pénalisera pas la liberté d’expression, ce qui n’est pas avéré, mais on peut dire également que l’article 13 serait d’une utilité limitée sur les plateformes visées.

5. Inefficacité du dispositif pour promouvoir la diversité culturelle

L’étude d’impact affirme que l’article 13 favorise la diversité, celle-ci étant supposée découler directement de la protection des ayants-droit.

Or, l’article 13 défavorise les sites contributifs et/ou non lucratifs, qui font eux aussi partie de la diversité, avec des contenus souvent libres de droits, donc d’une diffusion naturellement maximale. Les statistiques d’audience de Wikipédia le démontrent : 5e site mondial d’après l’étude Alexa. De plus, selon la fondation Wikimédia France, « les plateformes opteront pour un principe de précaution en bloquant plus de contenu que nécessaire ce qui réduira la diversité de ces plateformes en empêchant les personnes peu aguerries aux nouvelles technologies d’y participer ».

En résumé, l’article 13 :

- n’améliorerait en rien la situation des ayants-droit vis-à-vis des grandes plateformes, celles-ci ayant déjà déployé des systèmes de détection et de reversement de droits ;

- n’améliorerait en rien, non plus, la situation des ayants-droit par rapport aux plateformes non commerciales ou de faible audience, qui n’ont pas la capacité de déployer des systèmes complexes, ne pratiquent pas de contrefaçon des œuvres protégées autre qu’accidentelle donc marginale, et sont déjà en mesure de retirer les contenus illégitimes ;

- présente, en revanche, de grands risques de censure arbitraire, de confortement de la position des grandes plateformes par la création de barrières significatives à l’entrée, de disparition pure et simple des plateformes non lucratives, ou de repli de celles-ci sur de la diffusion de contenus figés, sans aspect participatif ;

- présente également des risques graves vis-à-vis de la liberté d’expression et de la diversité culturelle.

Pour toutes ces raisons, et comme l’ont également exprimé de très nombreuses associations et experts renommés, il semble préférable d’abandonner totalement l’article 13 en l’état actuel des connaissances et techniques.

Quelques références

Deux articles sur le blog de Julia Reda, la députée allemande qui a été en pointe sur la critique des articles 11 et 13 :

- https://juliareda.eu/2018/05/censorship-machines-link-tax-finish-line/

- https://juliareda.eu/2018/06/saveyourinternet/

La lettre ouverte de 70 experts de l’Internet https://www.eff.org/files/2018/06/12/article13letter.pdf

Les avis de l’EFF (Electronic Frontiers Foundation) https://www.eff.org/deeplinks/2018/06/internet-luminaries-ring-alarm-eu-copyright-filtering-proposal

D’autres sites faisant campagne contre l’article 13 :

https://www.liberties.eu/en/news/delete-article-thirteen-open-letter/13194

La position de la fondation Wikimédia :

https://blog.wikimedia.org/2018/06/14/dont-force-platforms-to-replace-communities-with-algorithms/

La position de Wikimédia France :

https://www.wikimedia.fr/2018/06/11/reforme-europeenne-droit-dauteur/

La position de la Quadrature du Net, plus complexe, qui a laissé perplexe bon nombre de gens (je déconseille le point 1 de l’argumentaire, non souhaitable à mon avis) :

https://www.laquadrature.net/fr/copyright_plateforme

Autres liens :

2 articles détaillés de l’indispensable nextinpact.com (abonnez-vous !) qui suit le sujet depuis longtemps :

- https://www.nextinpact.com/news/106658-le-filtrage-industrialise-sincruste-dans-directive-sur-droit-dauteur.htm

- https://www.nextinpact.com/news/106734-filtrage-deluge-critiques-sur-article-13-projet-directive-sur-droit-dauteur.htm

Pourquoi les mèmes sur Internet sont en danger https://www.bfmtv.com/tech/pourquoi-les-memes-sur-internet-sont-en-danger-1468454.html

Adieu mèmes et parodies ? Pourquoi « l’article 13 » menace Internet https://usbeketrica.com/article/adieu-memes-et-parodies-pourquoi-l-article-13-menace-internet