Acte I : la loi Hadopi

Les lois HADOPI 1 (Haute Autorité pour la diffusion des œuvres et la protection des droits sur Internet) et HADOPI 2 sont bien connues aujourd’hui. Suites de la loi DADVSI, ce sont de nièmes lois de commande destinées à protéger les ayants-droit de la musique et du cinéma, établies au nom de notre exception culturelle bien française (les états-uniens, ces vilains, ont tendance à considérer ces arts comme une industrie ; chez nous ils relèvent du ministère de la Culture, qui n’a heureusement rien à voir avec de sordides problématiques pécuniaires).

Nicolas Sarkozy veut ainsi civiliser Internet. Ce sont ses mots.

Or chacun sait, dans les milieux techniques liés à l’informatique et au réseau, qu’il n’existe strictement aucun moyen d’empêcher de façon fiable la copie d’une information numérique. Chacun le sait, et chacun l’a dit et répété. Cette analyse a été présentée en annexe du rapport Olivennes-Faure, qui avait été commandé par le gouvernement de l’époque pour recommandations préalables aux lois DADVSI puis HADOPI. Il ne s’agit pas d’un tour de passe-passe idéologique visant à légitimer le piratage éhonté des contenus — que la plupart des intervenants, sur le fond, condamnent –, mais de la simple constatation d’un fait.

En outre, chacun sait, et chacun a également dit et répété, que toute mesure de filtrage sur Internet est délicate à mettre en œuvre, d’une part pour des raisons techniques, d’autre part et surtout parce qu’elle met en jeu la liberté d’expression et d’information dans nos démocraties. Au minimum, on est en droit d’espérer que l’exercice de cette censure fasse l’objet d’une procédure judiciaire en bonne et due forme.

Cela n’a pas empêché le gouvernement et le rapporteur, Franck Riester, d’ignorer superbement tous ces avertissements pour faire voter la loi Hadopi, puis la loi Hadopi version 2 suite à la censure par le Conseil Constitutionnel d’un article important, dans des circonstances rocambolesques — lire les résumés sur Wikipedia dont j’ai donné les liens en haut d’article.

L’autorité créée par cette loi, la HADOPI, a commencé réellement son activité à la rentrée 2010, pour le modeste budget de 12 millions d’euros. Elle est supposée envoyer des courriers électroniques d’avertissement, avec l’aide des fournisseurs d’accès français, aux internautes qui copieraient illégalement des œuvres, se rendant ainsi coupables de contrefaçon ; puis, s’ils persistent dans l’erreur, à couper purement et simplement leur accès à Internet, à l’exception de la télévision et de la téléphonie. On note au passage avec intérêt la hiérarchie de valeurs imprimée dans l’esprit du législateur français : seuls les moyens de communication existant depuis plus de 70 ans ont l’honneur de se voir réellement protégés. Apparemment, Internet n’est pas aussi essentiel dans la vie de tous les jours que le téléphone et la télévision. Cette distinction n’a rien d’anecdotique, elle est au contraire au cœur du problème.

À ce jour, fin 2010, les résultats de la HADOPI ne sont pas au rendez-vous (une vraie surprise…). Le piratage ne semble pas avoir sensiblement régressé ; l’activité « pédagogique » (envoi de courriers électroniques), pourtant la plus facile à mettre en œuvre, semble très largement en deçà des quotas initialement annoncés de 50.000 adresses par jour. Cela semble étonnant, mais on verra plus bas qu’il y a une excellente explication pour cela.

Fin de l’acte I.

Acte II : le rabot fiscal

Suite à la crise financière, devant la nécessité de réduire le déficit du budget de l’État, plutôt que d’essayer de réduire son train de vie (cf par exemple ci-dessus : budget Hadopi), la solution française est bien connue : inventer de nouveaux impôts, augmenter les impôts existants et supprimer les niches fiscales.

Nous avons donc pu assister au rabotage récent du statut de jeune entreprise innovante (JEI) et du Crédit Impôt-Recherche ; rabotage qui désole beaucoup de créateurs d’entreprises de technologie.

Nous allons également assister dans les jours qui viennent à la remontée, déjà votée, du taux de TVA sur les accès ADSL, et qui s’applique au 1er janvier 2011. Cette mesure irrite les fournisseurs d’accès et abonnés Internet, qui ont la désagréable impression d’être une nouvelle fois les dindons de la farce.

Acte III : Wikileaks

Là dessus, interviennent les déclarations fracassantes d’Éric Besson, à peine arrivé à l’économie numérique (en remplacement de la regrettée Nathalie Kosciusko-Morizet), souhaitant éjecter Wikileaks des serveurs français qui l’hébergent par une lettre de mission à Pascal Faure (CGIET) qui restera dans les annales. On est là en plein dans la mission « civilisatrice ».

Nouvel émoi. Rigolade (jaune) lorsqu’une fuite du conseil des ministres laisse entendre que le président a confondu Wikipedia avec Wikileaks.

Acte IV : l’annonce du déjeuner de bloggueurs influents

Le président de la République, en homme de dialogue, bien conseillé par son entourage et manifestement conscient de la grogne et de la gêne grandissantes dans un secteur d’avenir qui lui tient particulièrement à cœur (au moins en discours), a cherché a renouer le contact en invitant quelques « personnalités » de l’Internet français pour un déjeuner informel à l’Élysée, le jeudi 16 décembre.

Et là, les choses deviennent très intéressantes pour qui veut s’informer sur le fonctionnement de notre démocratie, les pratiques de nos hommes politiques et la constitution de microcosmes, voire de connivences.

La liste des personnes invitées a été publiée :

- Xavier Niel, fondateur d’Iliad et patron de Free ;

- Jean-Michel Planche, fondateur d’Oléane et président de Witbe ;

- Daniel Marhely, président de Deezer ;

- Maître Eolas, blogueur et avocat ;

- Nicolas Vanbremeersch, blogueur (Meilcour.fr, ex-Versac) et fondateur de Spintank ;

- Eric Dupin, blogueur (Presse Citron) ;

- Jacques-Antoine Granjon, président de vente-privée.com ;

- Jean-Baptiste Descroix-Vernier, directeur de Rentabiliweb.

Un choix varié, entrepreneurs comme « blogueurs » relativement connus, qui n’ont pas dû se faire prier : quand on a l’honneur d’être invité à l’Élysée par le président de la République, en général, on y va ; ou on explique comme l’a très bien fait Korben pourquoi on a de très bonnes raisons de refuser.

Acte V : le passage de la loi LOPPSI

Par un amusant hasard du calendrier parlementaire, c’est la nuit précédant le repas suscité qu’a été votée en 2e lecture à l’assemblée la loi LOPPSI sous la férule de Brice Hortefeux et de Éric Ciotti. Chacun pouvait assister à sa retransmission en direct sur le site Internet de l’assemblée. Dans un hémicycle quasiment vide en fin de soirée, on pouvait voir les rares députés présents rejeter en bloc les amendements de bon sens proposés, y compris ceux provenant de députés UMP comme Laure de la Raudière ou Lionel Tardy. Sans parler évidemment de ceux des très rares députés d’opposition présents, Patrick Braouzec et Patrick Bloche. Un processus similaire à celui de l’adoption de la loi HADOPI, avec un résultat qui laisse à désirer pour les mêmes raisons : adoption du filtrage d’Internet vis à vis des contenus pédopornographiques sur simple décision administrative, sans intervention d’un juge, sans même la moindre transparence sur les sites visés. Préférence pour la censure des contenus plutôt que pour l’action contre les actes répréhensibles : la définition même de la tartuferie.

En somme, on préfère l’affichage médiatique de petits bras musclés plutôt que l’efficacité, comme dans le cas d’HADOPI.

Il ne faut probablement pas attendre grand chose du passage en 2e lecture au sénat pour améliorer la loi, il ne reste donc plus que le conseil constitutionnel.

Acte VI : le déjeuner

Le décor est posé, les lois sont quasiment votées dans leur ensemble d’une manière irréversible à court terme. Le moment est donc idéal pour que le président de la République, à l’approche de l’échéance électorale de 2012, puisse afficher la volonté de dialogue qui a toujours caractérisé son action. En effet, un calcul rapide permet de constater que les internautes échaudés par HADOPI et LOPPSI sont probablement un petit peu plus nombreux que les ayants-droit comme Johnny Hallyday, ses collègues et leurs producteurs. Transposé en voix aux élections de 2012, cela pourrait se traduire par un sérieux handicap pour le parti du président.

Cela serait encore plus fâcheux si l’HADOPI prenait sa pleine puissance d’envoi de courriers pédagogiques, se transformant par là même en arme de destruction massive de voix pour l’UMP.

C’est donc là que nous entrons de plain-pied dans la haute politique pré-électorale.

Quatre convives ont fait des compte-rendus directs ou indirect du repas, les voici. Je vous invite à les lire car il est difficile de les paraphraser :

On trouve également les traditionnelles photos sur le perron.

Les déjeuners à l’Élysée ne sont pas rares, mais, fait notable, c’est sans doute la première fois que l’on peut en lire plusieurs compte-rendus aussi directs, qui ne sont pas passés par le filtre aseptisant des médias classiques. Il est ainsi possible d’entrevoir les avis divergents, les points communs, le tout dans une grande transparence, dont on peut très sincèrement remercier les intéressés.

Acte VII : le Conseil

Pour résumer, le président veut établir un dialogue et, pour cela, propose en particulier d’établir une sorte de Conseil National du Numérique (pas forcément sous ce nom), qui était déjà dans les cartons après la fermeture des quelques instances similaires l’ayant précédé. Faire et défaire…

Outre l’opportunisme de la démarche, déjà noté ci-dessus ainsi que dans certains compte-rendus, on peut voir là le réflexe classique de l’homme politique lorsqu’il perd pied : créer une instance « représentative » (il ne s’agit pas forcément qu’elle soit réellement représentative, mais il faut quand même qu’elle en ait l’air). Cela permet :

- d’établir un dialogue, au moins apparent, ce qui est d’autant plus essentiel qu’en fait la messe est dite et les lois déjà votées — en entreprise, on appelait cela le management participatif ;

- de se débarrasser des patates chaudes en les déléguant ;

- d’avoir un fusible à faire sauter en cas de problème, par remplacement, comme dans un gouvernement ;

- de déléguer la communication des mauvaises nouvelles en utilisant éventuellement les titulaires de la fonction comme cautions morales en fonction de l’aura qu’ils ont pu acquérir par ailleurs dans une vie antérieure ;

- de montrer qu’on agit pour résoudre les problèmes ;

- de distribuer des postes honorifiques à des gens méritants, compétents ou populaires — en en faisant, le cas échéant et s’ils ne le sont déjà, des obligés, dans un classique échange de bons procédés ;

- éventuellement — l’improbable n’est jamais exclu –, d’avancer réellement.

Ce type de mécanisme est parfaitement connu, bien rodé et largement pratiqué. Il peut même fonctionner si les objectifs stratégiques sont clairement établis, ce qui est souvent le cas lorsqu’à l’extrême on souhaite calmer ou satisfaire tel ou tel lobby.

Mais dans le cas du numérique ? Que recouvre ce mot, d’ailleurs ? Et même si on se limite à Internet ?

L’écosystème d’Internet n’est pas homogène au même titre que l’industrie musicale, et ne peut donc pas constituer un lobby, même au sens noble du terme.

Internet est un croisement bizarre entre la technologie informatique, l’anarchie et l’esprit d’entreprise, mélange hétérogène difficile à appréhender pour les hommes politiques, et à plus forte raison par ceux qui n’y mettent pas les pieds.

Internet étant une agglomération d’intérêts variés et souvent divergents (particuliers de tous milieux et de tous âges, fournisseurs d’accès « purs » ou telcos reconvertis tant bien que mal, éditeurs de contenus, fabricants de matériel, universitaires, chercheurs, commerçants, PME…, en somme des citoyens de toutes origines), il semble difficile de le faire représenter en tant que tel ; problématique qui s’est déjà présentée, à plus petite échelle et de manière beaucoup plus informelle, pour le choix des convives à inviter…

Épilogue

En conclusion, la chose qui me semble évidente est que la création d’un tel conseil serait, avant tout, un bel aveu d’impuissance de la part du pouvoir politique. C’est l’ensemble des mœurs et mentalités politiques françaises qui doit être rénové et modernisé, adapté au numérique et à Internet, plutôt que l’inverse. La conclusion de Versac (paragraphe titré “manque d’ambitions”…) me semble bien résumer la question et aller dans un sens intelligent. Et comme le dit Jean-Michel Planche : on n’est pas à l’abri d’un coup de chance.

Quant à la malheureuse HADOPI, on voit qu’elle est coincée entre le marteau-ayants-droit et l’enclume-UMP-2012. S’il était facile de voter une loi d’affichage pour satisfaire les premiers, il va être plus difficile de jouer la montre pendant encore 18 mois pour envoyer le moins possible de courriers pédagogiques. D’ailleurs, aux dernières nouvelles, il semblerait que les ayants-droit commencent à découvrir la nature du problème…

Mise à jour du 21 décembre 2010 : Nicolas Sarkozy, le retour du candidat numérique (tout un programme), point de vue de Pierre Chappaz sur le déjeuner, et sur l’annonce officielle d’Éric Besson de ce jour (création du CNN, …).

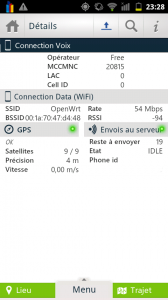

Avec l’application GSM Signal Monitoring: on obtient un peu plus d’informations. On note que le Cell-Id affiché n’est pas le même qu’avec Sensorly, pourtant il s’agit très probablement de la même antenne. On peut voir également à la couleur orange-rouge de la barre que l’application juge le niveau de réception (-91 dBm) relativement faible. Cela s’explique sans doute par la distance de l’antenne, de 600 mètres en zone urbaine dense. Théoriquement cette application donne la liste de toutes les antennes avec leur niveau de réception, en pratique sur mon téléphone il n’y en a jamais plus d’une visible à la fois, même avec un autre opérateur que Free.

Avec l’application GSM Signal Monitoring: on obtient un peu plus d’informations. On note que le Cell-Id affiché n’est pas le même qu’avec Sensorly, pourtant il s’agit très probablement de la même antenne. On peut voir également à la couleur orange-rouge de la barre que l’application juge le niveau de réception (-91 dBm) relativement faible. Cela s’explique sans doute par la distance de l’antenne, de 600 mètres en zone urbaine dense. Théoriquement cette application donne la liste de toutes les antennes avec leur niveau de réception, en pratique sur mon téléphone il n’y en a jamais plus d’une visible à la fois, même avec un autre opérateur que Free.